توضیحات

مثال روش steepest descent

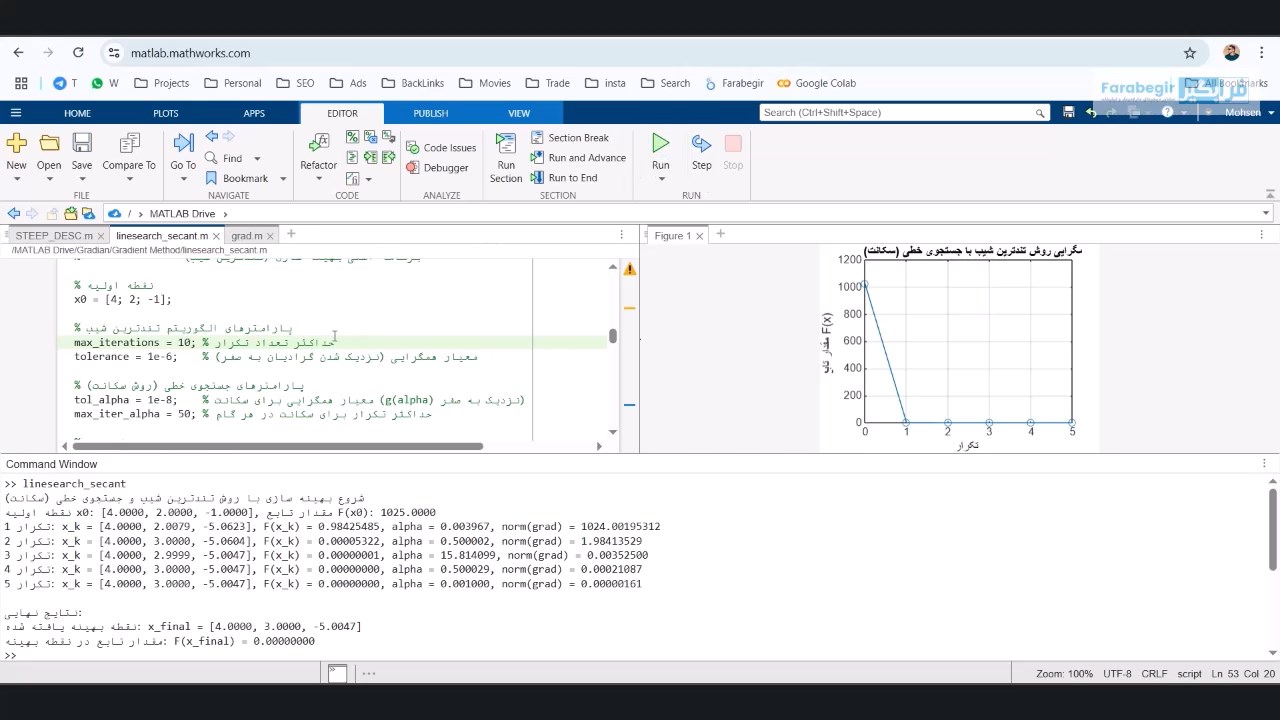

مثال روش steepest descent | در عصری که دادهها به منبع اصلی تحول تبدیل شدهاند و الگوریتمهای یادگیری ماشین نقش کلیدی در تحلیل و پیشبینی ایفا میکنند، درک مکانیزمهای بنیادین آنها اهمیت فزایندهای پیدا کرده است. در پس پرده مدلهایی که از ما میآموزند، الگوها را تشخیص میدهند یا حتی تصمیمگیری میکنند، اغلب یک فرآیند بهینهسازی تکراری پنهان است. مثال روش steepest descent دقیقاً همان نیروی محرکهای است که این مدلها را به سمت دقت بالاتر و کارایی بیشتر هدایت میکند، به آنها اجازه میدهد تا از طریق کاهش تدریجی خطا، به بهترین پیکربندی پارامتری دست یابند.

گرادیان چیست؟

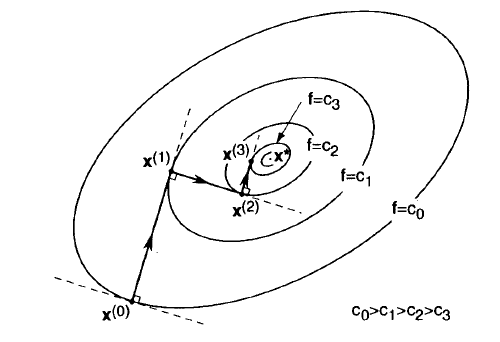

گرادیان، در واقع، یک مفهوم بنیادی در حساب دیفرانسیل چندمتغیره است که نقش محوری در درک و پیادهسازی مثال روش steepest descent ایفا میکند. این واژه به یک بردار اشاره دارد که شامل تمامی مشتقات جزئی یک تابع نسبت به هر یک از متغیرهای آن است. تصور کنید تابع مورد نظر ما، یک سطح سه بعدی پیچیده باشد؛ گرادیان در هر نقطه از این سطح، دقیقاً جهت تندترین “صعود” را به ما نشان میدهد، یعنی مسیری که اگر در آن قدم بگذاریم، بیشترین افزایش را در ارتفاع خواهیم داشت.

اهمیت گرادیان برای مثال روش steepest descent از آنجا ناشی میشود که هدف ما یافتن مینیمم تابع (پایینترین نقطه) است. اگر گرادیان جهت صعود را نشان میدهد، پس برای حرکت به سمت پایین، باید در جهت “منفی” گرادیان حرکت کنیم. این حرکت در جهت منفی گرادیان است که به ما تضمین میدهد در هر گام، در تندترین مسیر ممکن به سمت پایین حرکت میکنیم و به این ترتیب، به سرعت به سمت مینیمم تابع همگرا میشویم. به همین دلیل، محاسبه دقیق گرادیان در هر تکرار، حیاتیترین بخش الگوریتم تندترین شیب محسوب میشود.

نرخ یادگیری (Learning Rate) و نقش آن در روش تندترین شیب

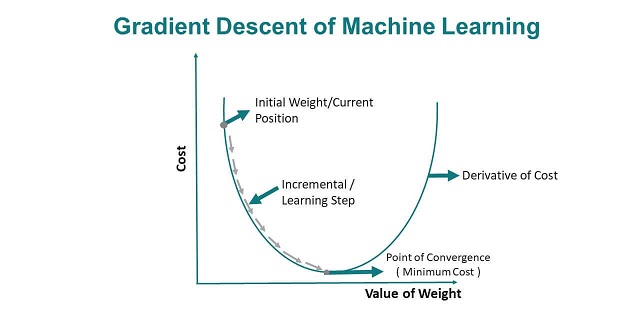

نرخ یادگیری، که معمولاً با حرف یونانی آلفا (α) نمایش داده میشود، یکی از مهمترین ابرپارامترها در روش تندترین شیب است که به شدت بر عملکرد و همگرایی الگوریتم تأثیر میگذارد. این پارامتر مثبت، اندازه “گام” ما را در هر تکرار، هنگام حرکت در جهت منفی گرادیان تعیین میکند. به عبارت دیگر، نرخ یادگیری مشخص میکند که با چه سرعتی میخواهیم پارامترهای مدل خود را بر اساس خطایی که شناسایی کردهایم، تنظیم کنیم.

انتخاب نرخ یادگیری مناسب یک هنر و علم است. اگر نرخ یادگیری بیش از حد بزرگ باشد، الگوریتم ممکن است از روی مینیمم “جهش” کند و به جای اینکه به سمت آن همگرا شود، به اطراف آن نوسان کند و حتی واگرا شود (یعنی مقدار تابع هزینه به جای کاهش، افزایش یابد). این پدیده را میتوان مانند پریدنهای بزرگ در یک دره با شیب زیاد تصور کرد؛ ممکن است در هر پرش، از کف دره عبور کنیم و به سمت دیگر آن برانیم، بدون اینکه هرگز به پایینترین نقطه برسیم. بنابراین، نرخ یادگیری بیش از حد بزرگ میتواند باعث عدم همگرایی یا نوسانات پایدار شود.

در مقابل، اگر نرخ یادگیری بیش از حد کوچک باشد، الگوریتم به کندی به سمت مینیمم همگرا میشود و ممکن است زمان زیادی طول بکشد تا به یک راه حل بهینه برسد. این سناریو شبیه قدمهای بسیار کوچک و آهسته در یک دره وسیع است؛ هرچند مطمئن به سمت پایین حرکت میکنیم، اما زمان زیادی برای رسیدن به کف دره نیاز خواهیم داشت. در موارد شدید، اگر نرخ یادگیری بسیار کوچک باشد، ممکن است الگوریتم قبل از رسیدن به مینیمم واقعی در یک مینیمم محلی گیر کند یا به دلیل محدودیتهای محاسباتی (حداکثر تکرار)، هرگز به نقطه بهینه مورد نظر نرسد. به همین دلیل، تنظیم دقیق نرخ یادگیری برای موفقیتآمیز بودن مثال روش steepest descent حیاتی است.

خدمات فرابگیر

- تبلیغات در فضای مجازی گوگل، اینستاگرام و فیس بوک.

- مدیریت صفحات اجتماعی اینستاگرام و فیس بوک.

- برنامه نویسی حرفه ای با جدیدترین متدهای روز دنیا

- طراحی وب سایت و سئو نمودن مطالب با جدیدترین راهکارها برای بازدید حداکثری مطالب

- خدمات طراحی سربرگ؛ کار ویزیت، لوگو و بسته مدیریتی

- پروژهای دانشجویی در زمینه تحقیق در عملیات، آمار و تصمیم گیری

- آموزش مجازی برای کاربران در زمینه های درخواستی دوره های موجود در وب سایت

باعث افتخارست که مجموعه ما تا کنون بیش از ۱۲۰۰۰ پروژه موفق در زمینه های متخلف ارائه نموده است که با مراجعه به بخش نمونه کارها در دسترس شما عزیزان قرار گرفته است. در صورتی که تصور می کنید پروژه مورد نظر شما در این دسته بندی ها قرار ندارد با تماس با تیم حرفه ای ما می توانید از مشاوره رایگان بهره مند گردید.

این مطلب در حال بهروزرسانی و گسترش است تا استاندارد سئو رعایت شود.

این مطلب در حال بهروزرسانی و گسترش است تا استاندارد سئو رعایت شود.

دیدگاهها

هیچ دیدگاهی برای این محصول نوشته نشده است.